「ChatGPT 安全嗎?」是許多企業與使用者的第一個疑問,但這個問題本身其實過於簡化了 AI 工具所涉及的資訊安全風險。多數人只專注在「我輸入的內容會不會被看見」,卻忽略了資料在 AI 模型背後的儲存方式、處理機制與系統整合風險。

首先,AI 工具的「使用方便性」往往讓人忽視它與傳統資安風險的不同。與過去靜態系統相比,像 ChatGPT 這樣的生成式 AI,不僅會接收資料,更可能透過後台學習或暫存處理,增加資料被誤用或洩漏的可能性。這種風險不是單純防火牆或權限設定就能完全防範

以近期某大型公司的內部資料外洩事件為例,員工為了工作方便,將程式碼輸入 ChatGPT 中進行除錯,結果導致敏感原始碼被留存在雲端模型中,成為潛在的洩密管道。這並非 AI「惡意」行為,而是使用者與企業對其機制理解不足所導致。

因此,與其問「它安不安全」,不如先思考:你是否真正理解了這些工具的運作邏輯與潛在風險?

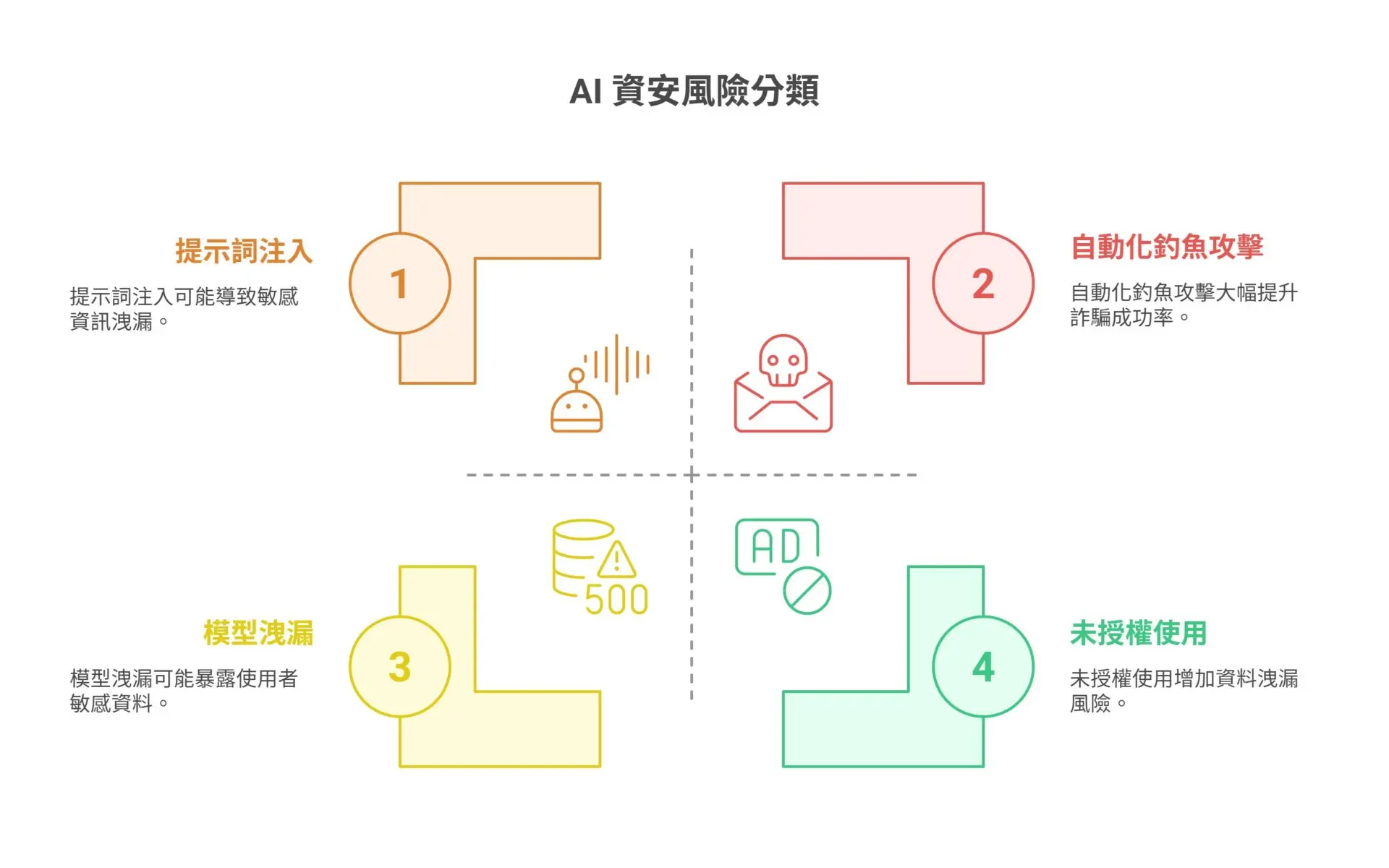

一、ChatGPT 帶來的 12 大資安風險與實際案例解析

ChatGPT 的強大功能雖然為企業帶來便利,但也衍生出一系列新的資訊安全風險。這些風險不只存在於技術層面,更在於使用方式與缺乏防範意識。以下是企業應高度警覺的 12 種 AI 資安風險,以及實際案例說明:

1. Prompt Injection(提示詞注入)

攻擊者透過隱藏指令操控 AI 回應,導致輸出敏感資訊或執行惡意動作。

2. Data Poisoning(資料投毒)

惡意資料被餵入模型訓練資料中,導致未來回應偏差或被操縱。

3. Model Leakage(模型洩漏)

使用者輸入的敏感資料被模型學習後,可能被其他人觸發類似內容。

4. Malicious Fine-tuning(惡意微調)

駭客自行微調模型,讓其看似正常卻內含惡意邏輯。

5. Phishing Automation(自動化釣魚攻擊)

AI 可產出語氣自然、無錯字的釣魚郵件,大幅提升詐騙成功率。

6. Identity Spoofing(身分偽造)

AI 模擬特定語氣與對話風格,冒充內部員工或高層。

7. Shadow AI(未授權使用)

部門私自使用外部 AI 工具,導致資料洩漏風險難以控管。

8. Output Injection(輸出注入)

回應內容中夾帶惡意連結或誘導資訊,透過使用者點擊擴散攻擊。

9. Model Misuse(模型誤用)

員工將 ChatGPT 用於不當場景,例如產出法律建議或醫療判斷。

10. Access Control Flaws(存取權限漏洞)

整合 ChatGPT 的 API 或插件時,權限驗證不足,可能開啟資料外洩窗口。

11. Training Data Exposure(訓練資料外洩)

上傳內部資料作為 fine-tuning 內容,卻未妥善隔離與保護。

12. Traceable Metadata(可追蹤元資料)

聊天紀錄、時間戳與帳號資訊可能被第三方擷取,造成額外風險。

舉例來說,近年已有假冒客服人員利用 ChatGPT 生成詐騙對話劇本,讓受害者信以為真;也有工程師將原始碼輸入 AI 工具後,不知資料被模型暫存、反向重組成潛在洩漏點。這些都顯示:AI 資安問題早已超越傳統防火牆邏輯,需要全新視角與對策來應對。

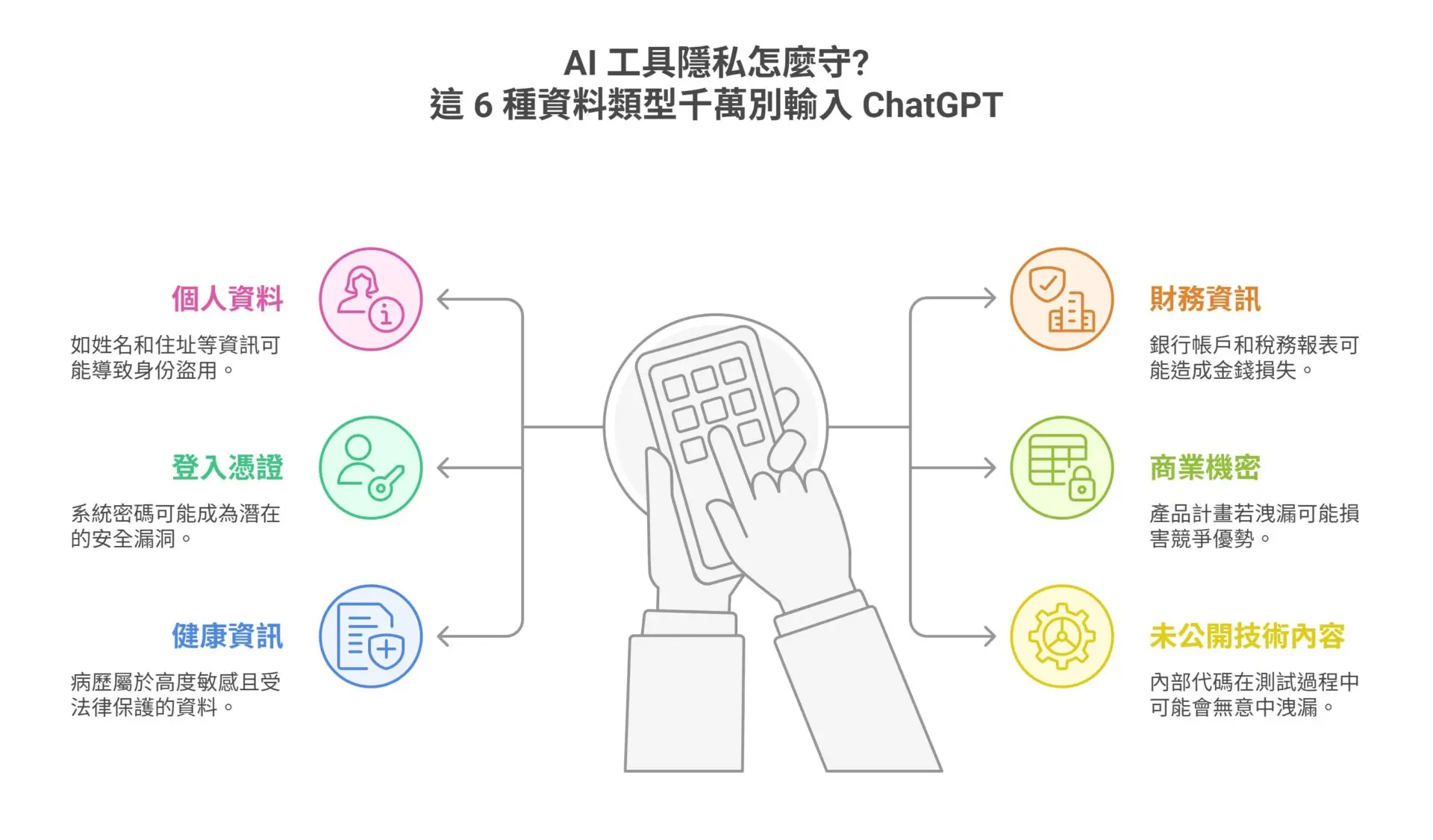

二、AI 工具隱私怎麼守?這 6 種資料類型千萬別輸入 ChatGPT

使用 ChatGPT 處理日常工作雖然便利,但過程中若不慎輸入敏感資訊,可能導致資料無法回收的資安風險。許多使用者誤以為「刪除聊天紀錄」就能移除一切資料,卻忽略了生成式 AI 的模型運作方式,部分內容有可能在訓練或暫存過程中留下痕跡。

以下六大類資料,強烈建議企業與個人使用者絕對避免輸入至 ChatGPT 或其他開放式 AI 工具中:

1.個人資料(PII):如姓名、身分證字號、手機號碼、住址等,容易成為身份盜用的攻擊入口。

2.財務資訊:如銀行帳戶、發票內容、稅務報表等,若外洩將引發金錢損失與合規風險。

3.登入憑證與密碼:無論是內部系統帳號密碼,還是 API 金鑰,一旦輸入即成潛在安全漏洞。

4.商業機密:如產品開發計畫、客戶名單、營運策略等,若被學習或擷取,將嚴重損及競爭優勢。

5.健康資訊:包含病歷、檢驗報告、保險紀錄等皆屬高度敏感個資,受法規(如 HIPAA、GDPR)保護。

6.未公開技術內容:如內部代碼、系統架構、演算法細節等,可能因測試或 debug 輸入而無意洩漏。

此外,「刪除聊天紀錄」僅限於使用者界面層級的資料清除,並不代表這些輸入已完全從模型記憶或暫存區中移除。即使 OpenAI 提供非訓練模式選項,仍需主動開啟並確認其應用場景,不能將其視為萬無一失的保險。

建議企業建立內部使用政策,清楚列出禁止輸入的資料類型,並以清單或圖解方式讓使用者易於理解與遵循。個人使用者也應養成基本資料保護意識,把 AI 工具當成公開平台來看待,凡是不會貼在論壇的資訊,就不要輸入。

三、企業最容易忽略的 ChatGPT 第三方整合漏洞

許多企業導入 ChatGPT 或其他生成式 AI 工具時,往往不只使用原生介面,而是透過外部應用、API 整合、甚至插件(Plugin)來強化功能與擴展應用場景。然而,這些便利性的背後,卻隱藏著一系列「看不見」的資安風險。

最大風險之一來自於 資料傳輸過程的加密與授權驗證不足。當企業將內部資料透過 API 傳送至外部服務時,若未使用加密通道或設定明確的存取權限,極可能導致資料被攔截或非法存取。例如,有些外掛應用可能要求讀取整個對話歷程,卻未清楚說明資料是否儲存、與誰共享。

另一個常見問題是 授權與驗證機制混亂。在多層整合架構下,若未釐清各系統之間的存取權限(如誰可以讀取、誰可以寫入),容易出現所謂的「Shadow AI」——部門或個人私自接入未經審核的 AI 工具,使用方式難以控管,風險無從追溯。

實務中已有企業在將 AI 整合至 CRM 系統時,發現用戶回覆內容不慎被同步至雲端,導致客戶資料外洩。這並非技術漏洞,而是整合設計中缺乏資安審查與預警機制的結果。

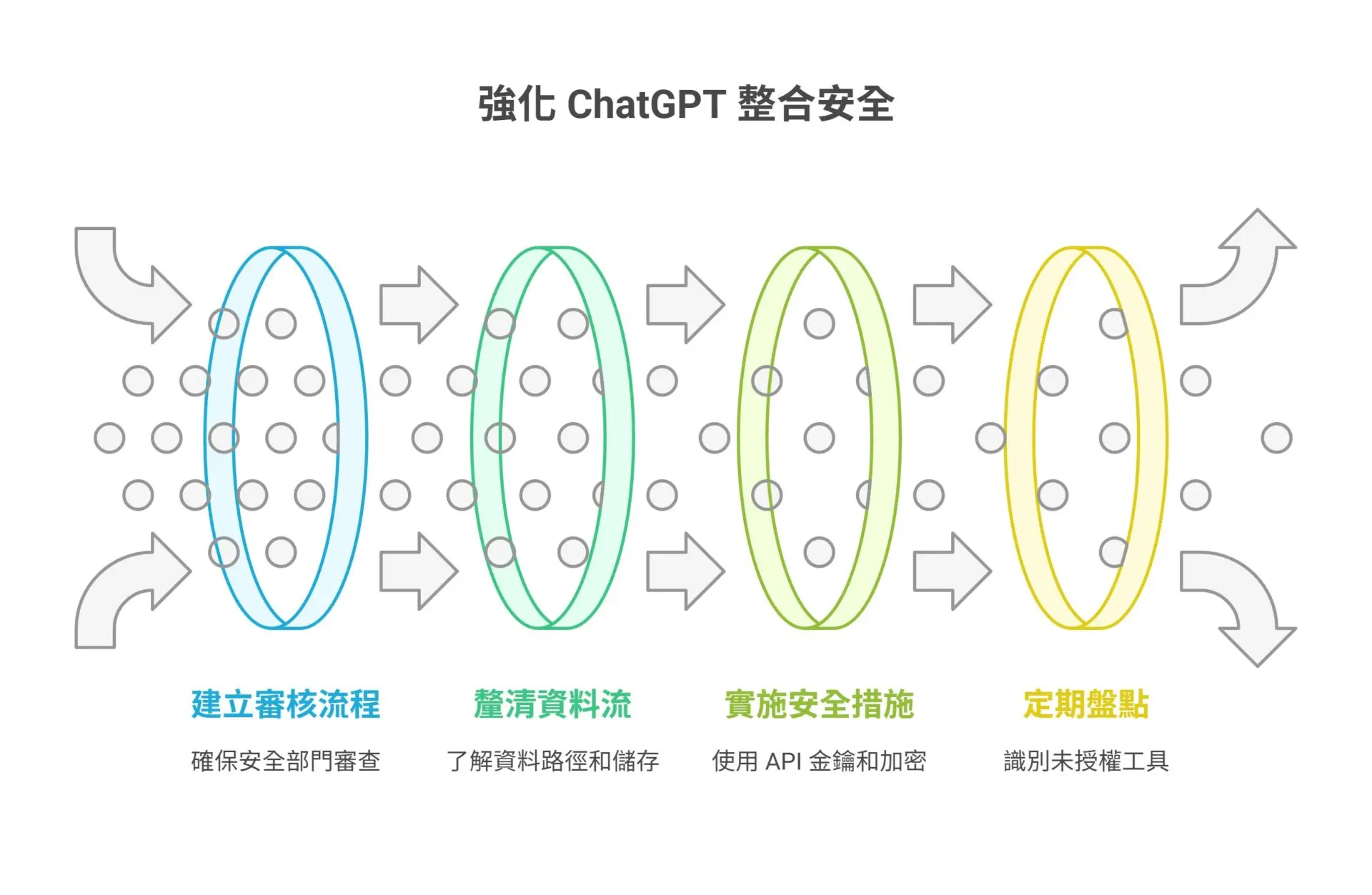

因此,企業在導入任何 ChatGPT 外掛、API 或第三方整合方案時,應採取以下策略:

1.建立「第三方接入審核流程」,確保每一項整合經過資安部門檢視

2.釐清資料流向與儲存方式,並設定最小授權原則(Least Privilege)

3.使用 API 金鑰與傳輸加密協定,避免明文傳輸與憑證外洩

4.定期盤點整合應用,防止未授權工具成為風險來源

整合是擴展應用的利器,但若無清楚規範與防護,將可能成為最致命的漏洞入口。

四、想保護企業與使用者,這些 ChatGPT 安全機制與設定你該啟用

面對生成式 AI 所帶來的新型資安挑戰,許多風險其實可以透過 ChatGPT 本身內建的安全設定與使用習慣來大幅降低。企業與個人若能善用這些機制,便能在享受 AI 效率的同時,也兼顧資訊保護。

1.關閉資料訓練功能(Turn off Chat History & Training)

使用者可在設定中關閉「Chat History & Training」,避免對話內容進入模型訓練流程。這項功能適合處理機密性較高的業務內容,但需注意:即使關閉,對話仍可能被暫存一段時間以進行服務監控,仍應謹慎輸入資料。

2.使用臨時聊天模式(Temporary Chat)

部分進階版本(如 Enterprise 或 Team 版)提供「臨時會話」功能,不保留歷史紀錄、不做訓練,適合短期機密溝通或限時任務使用。

3.啟用兩步驟驗證(2FA)

確保帳號不被非法登入的基本防線,尤其對於開啟 API、整合應用等管理者帳號,更應強制設定多重驗證。

4.採用 ChatGPT Enterprise 版本

Enterprise 版本具備更完整的安全架構,包括:

a.所有資料預設不進入訓練流程

b.支援單一登入(SSO)與企業身份驗證

c.擁有使用者權限控管與活動日誌

d.符合 SOC 2、ISO 等資安認證標準

雖然成本較高,但對中大型企業而言,是降低法遵與資安風險的關鍵投資。

5.搭配第三方資安輔助工具

企業可結合其他資安解決方案,補強 ChatGPT 周邊的保護層,例如:

a.使用 VPN 確保連線過程加密

b.採用密碼管理工具管理 API 金鑰與帳號存取

c.部署 DLP(資料外洩防護)系統監控 AI 工具使用過程

資安防護不應只靠工具原生設定,而應是「多層次防禦架構」的總體策略。將這些機制正確啟用,才能讓 AI 成為助力,而非風險源頭。

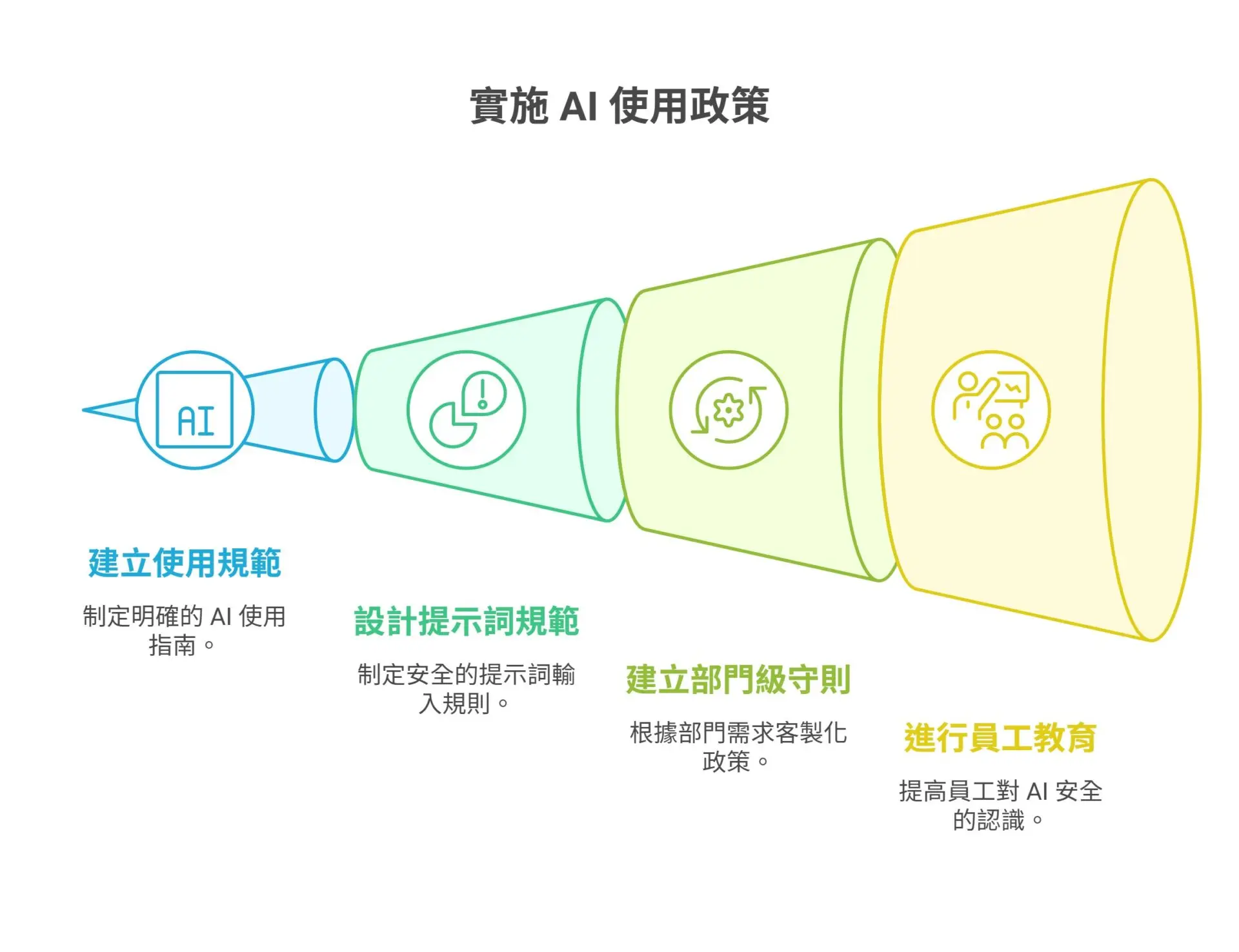

五、企業如何設計「AI 使用政策」來落實 ChatGPT 安全性?

隨著 AI 工具逐步成為員工日常工作的輔助利器,企業不該再只是「允許使用」,而應進一步制定明確的「使用規範」。設計一套可落地、可執行的 AI 使用政策,是確保 ChatGPT 安全應用的基礎。

1.從「允許使用」變成「規範使用」

政策的核心不是禁止,而是建立清楚的使用邊界與責任界定。明確定義哪些部門可使用 AI 工具、可應用於哪些任務,以及哪些情況下必須事先申請或取得授權。例如:行銷可用於初稿撰寫,但法務合約不得使用 AI 編寫。

2.設計提示詞(Prompt)輸入規範

針對提示詞撰寫,企業應建立「輸入限制規則」,明確列出不得輸入的資料類型(如個資、密碼、機密代碼等),並提供安全的 prompt 設計範例,降低誤用風險。可搭配表格與提示詞審查工具輔助落實。

3.建立部門級使用守則與稽核機制

不同部門的使用情境與風險程度不一,建議依部門需求,客製化制定簡化版政策指引。例如客服部門應避免複製客戶對話輸入 AI 工具,工程部門則須標註測試資料來源與用途。

4.導入員工教育與資安意識訓練

AI 工具的風險不僅是技術問題,更是認知落差。企業應定期對全體員工進行 AI 使用安全培訓,內容可包含案例分析、常見誤區、prompt 設計工作坊等,特別針對非技術部門強化基本資安意識。

一套完善的 AI 使用政策,不僅能防範資料外洩與風險擴散,也能讓企業在享受 AI 效率的同時,守住安全與信任的底線。從制度、工具到教育三方並進,才能真正實現安全導入與永續應用。

建立 ChatGPT 安全評估與監控機制的實務指南

即便企業已制定 AI 使用政策,若缺乏實際的監控與稽核機制,潛在風險仍可能在日常應用中悄然擴散。ChatGPT 的特性使得每一個 prompt 都可能成為潛在風險源,因此建立安全評估與監控機制是企業 AI 管理中不可或缺的一環。

1.建立「輸入/輸出審查」流程

企業可透過提示詞預審(Prompt Review)系統,對高風險部門所撰寫的提示詞進行審查。重點包括是否含有個資、機密、違規語句等。同時也應對 AI 輸出的內容進行抽樣審核,檢視其是否洩漏內部結構、策略、敏感資訊。

2.部署自動化監控機制

透過 Log 記錄、AI 使用行為分析工具,可即時追蹤使用頻率、輸入內容長度、API 呼叫次數等,識別異常行為。例如,某部門突然大量輸入系統代碼或使用深夜非工作時間操作,就可能是風險訊號。

3.建立即時通報與風險響應流程

當 AI 工具輸出異常內容,或發現高風險使用模式時,應能自動觸發警示並通報資安團隊。同時需建立「AI 使用異常報告」制度,鼓勵員工主動回報可疑情況,並設置快速響應處理小組。

4.導入第三方安全模組與開源工具

可結合如 Nightfall、Protecto.ai 等專門針對生成式 AI 的資料防護服務,進行實時內容掃描與分類。若有資源,也可導入如「OpenPromptGuard」等開源方案,自訂提示詞風險規則,提升靈活性與透明度。

建立這些機制並非為了限制 AI 使用,而是為了讓 AI 真正成為安全、可控的企業資產。監控與稽核不是事後補救,而是 AI 策略成功與否的關鍵前提。

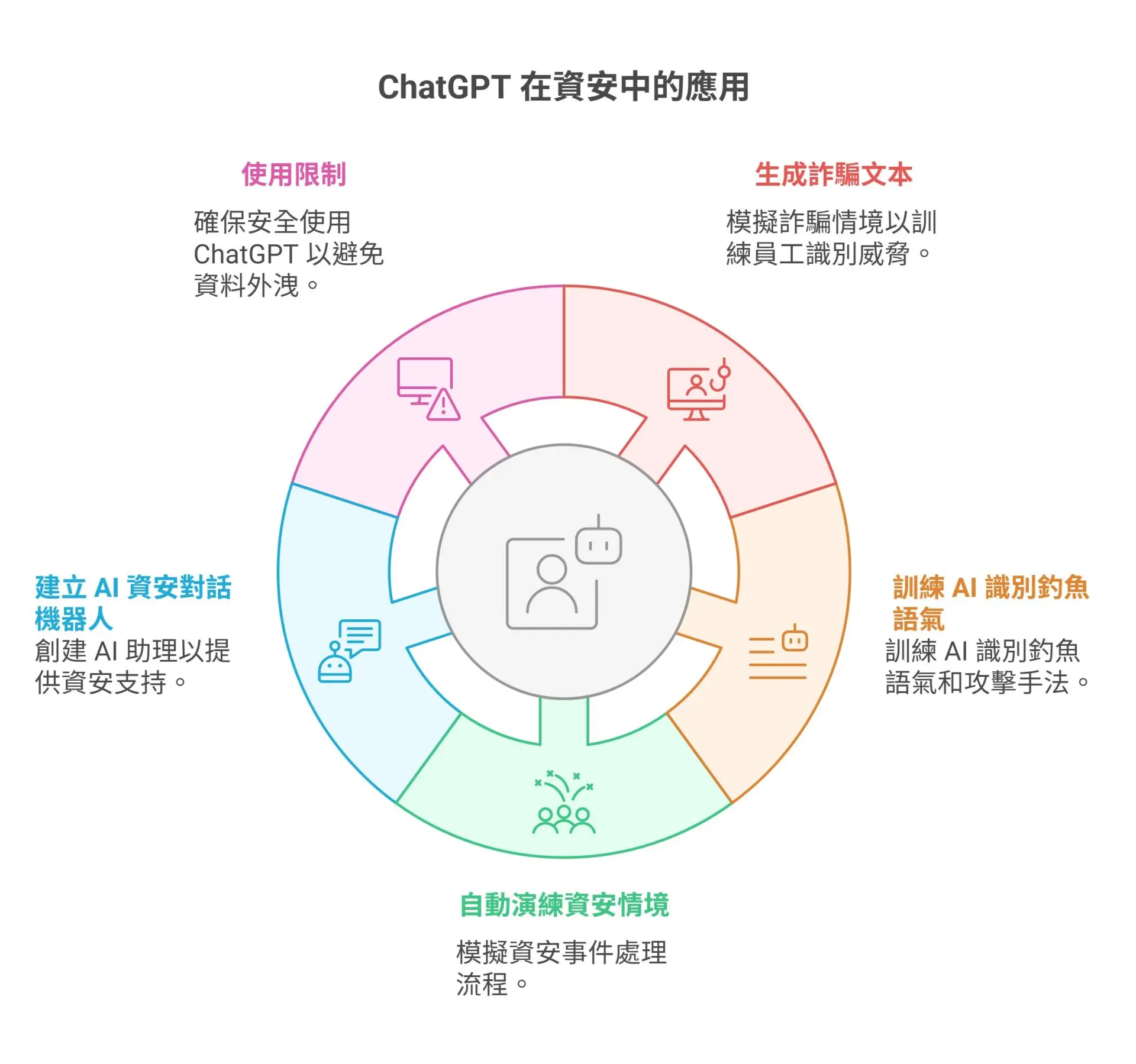

從「善用」到「防範」:ChatGPT 也能成為資安部門的利器

ChatGPT 雖然本身存在潛在風險,但若能正確運用,反而能成為資安團隊手中的「模擬工具」與「訓練助理」。透過合理設計提示詞,資安部門不只可以預測攻擊手法,更能建立內部防禦演練與教育機制。

1.生成詐騙文本範例

透過提示設計,讓 ChatGPT 模擬真實世界中的社交工程攻擊情境,例如假冒銀行客服、釣魚郵件、勒索信件等。這些範例可用於訓練員工識別潛在威脅,提高整體警覺性。

2.訓練 AI 識別釣魚語氣與攻擊手法

資安人員可讓 ChatGPT 接收一系列內部信件範例,然後模擬攻擊變體,評估系統防禦是否足夠,並作為郵件防詐機制的測試基礎。例如模擬語氣變化、假連結隱藏方式等。

3.自動演練資安情境與應對腳本

ChatGPT 可協助模擬資安事件處理流程,從發現異常、通報、回應到收尾溝通,建立多種情境腳本。這些內容可應用於資安演練、桌上兵棋推演(Tabletop Exercise)等,強化跨部門應變協作能力。

4.建立 AI 資安對話機器人

企業可訓練專屬資安 AI 助理,提供即時查詢功能(如密碼設定規範、資安政策摘要)、教育素材推播,甚至能協助新進員工完成資安入職訓練。將 AI 轉化為內部知識中心,降低資安人員負擔。

5.使用限制與邊界設計仍不可少

即使將 ChatGPT 作為資安工具使用,仍應設定清楚的資料輸入邊界,避免在測試過程中誤輸機密資訊。同時建議在封閉環境中操作,或使用不連網的本地模型以降低外洩風險。

從被動防範轉向主動模擬與教育,正是 AI 工具在資安領域的升級方向。若善用 ChatGPT,資安團隊不只是「監管者」,更能成為推動企業 AI 安全文化的關鍵推手。

面對 AI 工具風險,企業與用戶都不能再當「順用者」

面對 ChatGPT 等生成式 AI 工具帶來的便利與風險,企業與使用者不能再以「會用就好」的心態看待這項技術。真正的挑戰在於,我們是否具備足夠的敏感度與制度設計能力,能辨識並管控每一次輸入、整合與應用所可能帶來的安全風險。

AI 工具的未來只會越來越強大,也勢必牽動更多關於資料隱私、合規性與倫理風險的議題。資安,不該是事後處理的補救機制,而應是從策略設計、教育培訓、技術監控到流程落實的全方位管理工程。

對個人使用者來說,請記住一個原則:「你不會公開張貼的內容,就不要輸入給 AI。」對企業來說,建立內部 AI 使用政策與監控機制,應成為每個數位轉型專案的標準配備。

最後,我們也建議參考以下資源,持續強化知識與實務能力:

OpenAI 官方安全指南

企業 AI 資安政策模版(如 NIST、ISO 指引)

自我檢測工具:ChatGPT 使用風險評估清單

AI 不是風險本身,忽視風險才是最大的危機。從「順用者」轉為「有意識的使用者」,才是面對未來的正確姿態。

了解更多,請參考先行智庫 AI 解決方案服務,讓專業團隊成為你邁向未來的最佳夥伴。

如有任何問題或需求,請填寫以下表單,我們將竭誠為您解答!

您也可以透過以下按鈕了解更多資源: